Diplomáticos de todo el mundo se reunieron en Ginebra del 11 al 15 de abril, para celebrar la tercera Reunión Informal de Expertos de las Naciones Unidas sobre Sistemas de Armas Letales Autónomas, comúnmente conocidas como robots asesinos.

El objetivo de estas reuniones es avanzar en la decisión de cómo el uso de estos sistemas debe estar regulado por el derecho internacional humanitario. Los puntos de vista resultaron de lo más variado y acorde a la situación que cada país está viviendo y hacia la que tiene pensado evolucionar.

Teniendo esto en cuenta, no es extraño ver posturas completamente enfrentadas entre Pakistán y Palestina que sufre repetidos ataques de aeronaves no tripuladas y están a favor de una prohibición total. Por su parte, Reino Unido está a favor de no realizar ningún tipo de nueva regulación.

La visión común es que para la regulación de estos sistemas se debe partir y asumir las leyes actuales que rigen el derecho internacional humanitario, como que los robots no pueden ignorar los principios de distinción entre civiles y combatientes, la proporcionalidad en la escala de ataque o su uso para cometer genocidio, masacres y crímenes de guerra. Del mismo modo, los oficiales del ejército que controlan los robots tendrían responsabilidad de las acciones de los mismos, al igual que la tendrían de los humanos que comandan.

Según publica Sean Welsh, candidato a doctor en ética robótica por la Universidad de Canterbury en un artículo publicado en The Conversation, las posturas que se debatieron se resumieron en cuatro propuestas que atienden al grado de implicación de los seres humanos y la autonomía de estos sistemas.

Propuesta 1: aplicar las leyes existentes

La posición del Reino Unido es que el derecho internacional humanitario existente es suficiente para regular las tecnologías emergentes en la inteligencia artificial y la robótica.

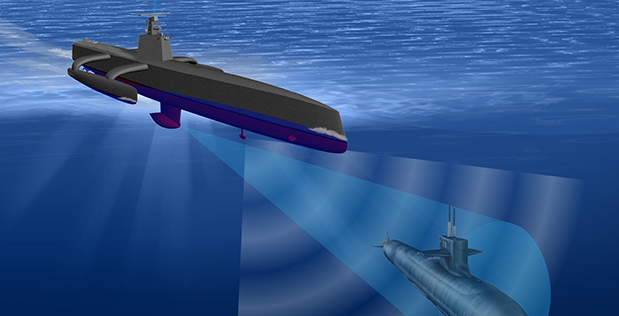

Su argumentación se centró en que el derecho internacional humanitario ya fue suficiente para regular los aviones y submarinos cuando estos aparecieron y puede seguir siendo aplicable en su mayor parte para los sistemas de armas autónomos.

Su propuesta es la de incluir una programación que permita a estos sistemas regirse por la normativa existente.

Propuesta 2: prohibición del aprendizaje automático

La delegación francesa indicó que una prohibición total sería prematura y que están abiertos a aceptar la legalidad manteniendo a humanos en el proceso. Esto significa que estos sistemas pueden seleccionar objetivos y disparar de forma autónoma, pero los seres humanos establecerían las reglas de combate.

Más concretamente indicaron que apoyarían una prohibición a sistemas similares a AlphaGo, que recientemente venció al humano campeón del mundo, argumentando que en sistemas como el control de misiles podrían adquirir comportamientos impredecibles.

Propuesta 3: prohibición de decisiones autónomas con una implicación mayor de humanos

Las delegaciones de Holanda y Suiza sugirieron que la implicación humana en el proceso de toma de deciones de estos sistemas fuera más amplio para asegurar el cumplimiento con la ley humanitaria internacional.

El Reino Unido, Francia y Canadá se mostraron en contra de esta prohibición, afirmando que podrían ser moralmente superiores a los soldados humanos, ya que estas máquinas serían más exactas, más precisas y menos propensas a malas decisiones causadas por el pánico o la venganza.

Los opositores contrargumentan que en ambientes saturados o ocluidos podrían tomar decisiones incorrectas y moralmente inaceptables. La Santa Sede y otras trece naciones piensan que una intervención humana en tiempo real en la decisión de acabar con vidas humanas es moralmente necesaria, por lo que siempre debe haber un ser humano en la intervención.

Sin embargo, esta posición presenta una excepción con armas defensivas tales como las minas navales, que han existido desde la década de 1860, o el sistema Phalax CIWS empleado para la defensa contra misiles antibuque.

Propuesta 4: Prohibición total

Pakistán y Palestina apoyarán cualquier medida para prohibir el uso de cualquier tipo de dron o arma teledirigida de similares características. Esto significa que aunque el control sea total por parte de un operador humano, estos países se muestran totalmente contrarios al uso de cualquier tipo de sistema no tripulado.

Validez y siguientes pasos

La reunión de Ginebra fue una reunión informal de expertos para aclarar las definiciones y alcanzar consenso sobre lo que podría llegar a ser prohibido o regulado en un tratado. Al ser una reunión informal no se realizan votaciones ni se elaboran tratados.

Atendiendo a experiencias anteriores, el siguiente paso consistiría en la elaboración de un panel de expertos gubernamentales para continuar las discusiones. Entre tanto estaría vigente la normativa actual sobre derecho internacional humanitario, tal como se ha explicado en la primera posición.

Vía: The Conversation.