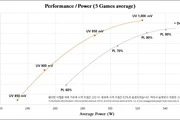

Puede que la RTX 4090 tenga un consumo máximo en carga de 450 vatios, pero eso no quiere decir que siempre vaya a consumir eso. En muchos juegos se sitúa sobre los 350 a 400 vatios sin limitar la tasa de fotogramas, y cuando se limita en una pantalla UHD de 144 Hz el consumo se desploma a los 250-300 vatios como indiqué en el análisis de la RTX 4090. Eso sin entrar en el terreno del infravoltaje o undervolting, que se pueden conseguir caídas adicionales. Es lo que han mirado en un análisis con resultados interesantes como una caída del 8 % del rendimiento con una caída del 50 % del consumo.

Los juegos mirados son Cyberpunk 2077, Marvel Spider-Man Remastered, Forza Horizon 5, Lostark y PUBG Battlegrounds, por lo que hay cierta variedad. Cyberpunk 2077 con el trazado de rayos activo sí puede consumir entre los 400 y 450 vatios a UHD y máxima calidad, que es como se han probado todos los juegos. Más abajo podéis ver unas gráficas que indican que limitar el consumo incluso un 30 % apenas produce una caída significativa del rendimiento medio, por debajo del 3 %.

He comentado multitud de veces que juego en un NUC 11 Enthusiast porque mi casa es lo único que permite durante el verano en Madrid, dando la fachada al sur y sin aire acondicionado. La tarjeta de este NUC, una RTX 2060 de movilidad, está configurada a 120 vatios pero ajustando en Afterburner la curva de voltaje puedo reducir el consumo a los 60-80 vatios según el juego sin casi pérdida de rendimiento. En todas las tarjetas gráficas es lo mismo.

Aunque la RTX 4090 consuma hasta 450 vatios no significa que tenga que consumir tanto. Pero requiere de dedicarle un tiempo y de crear perfiles de voltaje para según el juego, porque unos son más sensibles en cuanto a las frecuencias máximas y otros en cuanto a los sombreadores máximos. El fuerte paralelismo de las unidades de procesamiento gráfico hace que cuantos más sombreadores (o llamadlos núcleos) hay que mantener alimentados más difícil es hacerlo. Las acciones pedidas a las GPU, llamadas primitivas, se pueden trocear hasta cierto punto, y dentro de la GPU hay ciertos tiempos de espera, por lo que te da igual si las procesan a 1 GHz que a 3 GHz. Si no hay primitivas que procesar, no se pueden mantener alimentados los sombreadores.

A lo que voy es que desde un primer momento he dicho que frecuencias de 2.5 GHz o incluso 3 GHz en una tarjeta gráfica es absurdo. Lo he dicho en noticias, lo he dicho en comentarios, y he dicho que lo mejor es toquetear durante un rato los voltajes de la tarjeta gráfica. Si no se quiere, entonces con limitar el consumo es suficiente. Eso sí, estas pérdidas mínimas con fuertes reducciones de consumo son posibles en la RTX 4090 por ese troceo de las primitivas y su alto número de sombreadores (16 384), donde importa menos la frecuencia. En otras la mejora puede ser mucho más discreta si se hacen recortes de frecuencia/voltaje tan agresivos.

Me parece absurdo lanzar un producto tan subido de frecuencias, como le ocurre a los Ryzen 7000, para ganar un 1 % o 2 % de rendimiento extra, o para mantener los fotogramas mínimos un poco más arriba.

Vía: Videocardz.