ARM sigue expandiendo su propiedad intelectual con nuevas arquitecturas que licenciar a sus clientes, y la última llega con un nuevo tipo de núcleo y una nueva unidad de procesamiento neuronal (NPU). Se trata de los Cortex-M55 y Ethos-U55, aunque a esta última la califica de micro-NPU, buscando potencia a bajo consumo en el menor espacio posible al combinarla con un núcleo Cortex-M.

Esta serie está orientada a microcontroladores más que a los habituales sistemas en chip (SoC), pero estamos en 2020 y la inteligencia artificial se empieza a usar para todo. Más especificamente todo lo relacionado con el aprendizaje automático que permite identificar objetos en imágenes, y para sistemas robóticos es indispensable.

ARM habla de una potencia en aprendizaje automático del Ethos-U55 que es 480 veces superior a los predecesores Cortex-M, mientras que mantiene la compatibilidad con las bibliotecas de IA de código abierto como CMSIS-NN, CMSIS-DSP, o TensorFlow Lite para microcontroladores.

El Cortex-M55 dispone de una potencia en procesado de señales digitales cinco veces superior y quince veces en aprendizaje automático. Usa la microarquitectura Armv8.1-M con ciento cincuenta nuevas instrucciones escalares y vectoriales. Por otro lado, el Ethos-U55 se puede combinar con los núcleos Cortex-M como los M55, M33, M7 y M4, y se puede configurar con 32 a 256 multiplicadores-acumuladores, una unidad necesaria para calcular convoluciones en redes neuronales.

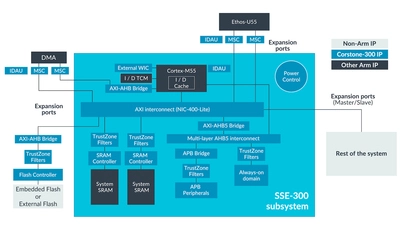

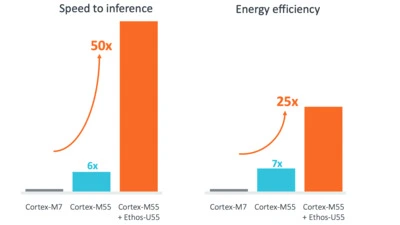

La compañía ha mostrado un diseño de referencia para la integración de un Cortex-M55 con un Ethos-U55 para que sus clientes lo usen como base, pero también para demostrar lo que se puede conseguir con estos nuevos diseños. Integra otras tecnologías de seguridad y fiabilidad, así como de acceso a sistemas externos y al resto del equipo en el que se integre. En un uso real, este diseño de referencia llamado Corstone-300 permite aumentar la velocidad de inferencias cincuenta veces con un consumo energético que es veinticinco veces mejor respecto al popular Cortex-M7.

Vía: AnandTech.