Nvidia ha hecho múltiples anuncios en su conferencia inaugural de la GPU Technology Conference, un congreso que organiza ella periódicamente para mostrar novedades. En esta ocasión todos han tenido que ver con la inteligencia artificial y el sector profesional, con una interesante Quadro GV100 basada en el chip GV100 de arquitectura Volta para los equipos de sobremesa. Pero para la computación ha anunciado también el equipo DGX-2 que tiene un coste de 400 000 dólares y aporta una potencia de cómputo en inteligencia artificial de 2 PFLOPS.

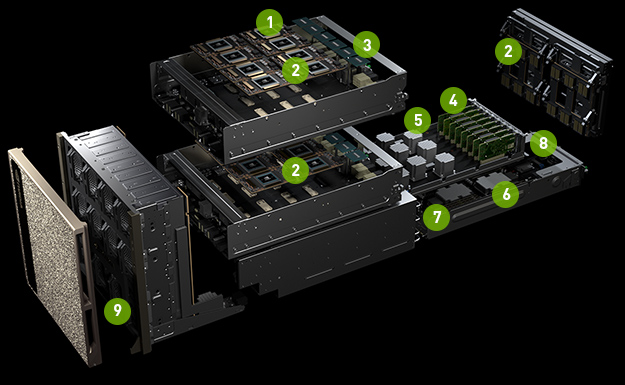

Eso lo consigue gracias a los núcleos tensoriales de las dieciséis Tesla V100 que incluye de 32 GB de HBM2 cada una para un total de 512 GB. El sistema tiene un sistema de refrigeración personalizado ya que las dos placas de ocho GV100 cada una disponen de refrigeración pasiva, y la activa la aporta el chasis como en cualquier centro de datos. Su consumo es de 10 000 vatios, y tiene un peso de 158 kg. También se puede configurar con hasta 1.5 TB de memoria DDR4, y hasta 60 GB de almacenamiento PCIe 3.0 ×4 NVMe. También incluye el equipo ocho conectores de 100 Gigabit Ethernet para que no sea tampoco un problema el ancho de banda con internet. Los procesadores que incluye el equipo son Xeon Platinum.

La comunicación entre todas las tarjetas gráficas se realiza mediante una interconexión NVLink 2, que permite una conexión GPU a GPU de 300 GB/s de transferencia. Se trata de una interconexión no bloqueante y que conecta a todas las GPU con todas las demás. Esto permite que la memoria de vídeo de todas las tarjetas gráficas conformen un único fondo para todo el sistema, aunque se mantiene la penalización de latencia por acceder a la memoria de otra tarjeta. En general, Nvidia apunta a que el rendimiento total del sistema es de hasta diez veces el del DGX-1, aunque depende de para qué tarea.

Vía: AnandTech.