En el competitivo mundo de la inteligencia artificial, donde empresas como OpenAI han invertido sumas considerables para desarrollar los más avanzados grandes modelos de lenguaje, una compañía china ha logrado un avance notable. 01.AI, liderada por Kai-Fu Lee, ha entrenado un modelo comparable a GPT-4 utilizando solo 2000 tarjetas gráficas, y no aceleradoras específicas, con una inversión de 3 millones de dólares, una fracción de los 80 a 100 millones que OpenAI destinó para entrenar a GPT-4.

Lee destacó que, ante la limitada disponibilidad de las GPU debido a las sanciones estadounidenses a China, su equipo se enfocó en maximizar la eficiencia. Implementaron soluciones innovadoras, como transformar problemas de computación en problemas de memoria para evitar cuellos de botella, desarrollar un sistema de caché multinivel, o un motor propio de inferencia, lo que resultó en una reducción significativa de los costes de inferencia a aproximadamente 10 centavos por millón de tókenes, mucho más bajo que lo que suele costar en la industria.

Lo que no entienden en EUA es que al prohibir la venta de maquinaria litográfica o de otra índole para evitar la mejora en IA de China lo que consiguen al final es que los chinos recurren a su ingenio para suplir la falta de máquinas y dispositivos que incluyan tecnología estadounidense. Así que ahora pueden entrenar, supuestamente, grandes modelos de lenguaje con un coste infinitamente menor que en Occidente. Bravo.

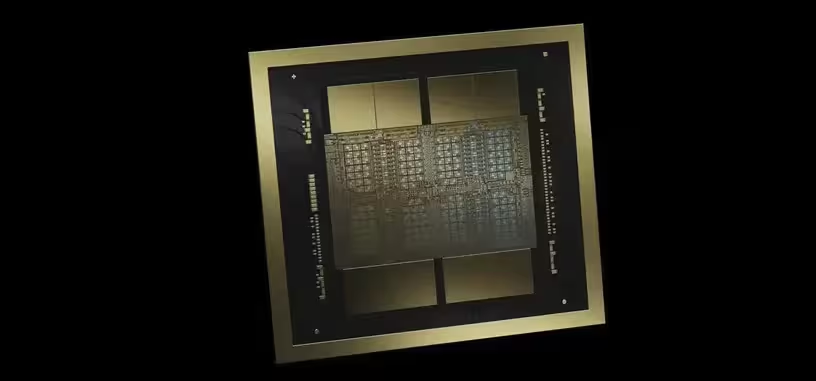

En el sector de los semiconductores, si no pueden acceder a la maquinaria de luz ultravioleta extrema entonces optimizan el uso de luz ultravioleta profunda mejorando la técnica de patrones múltiples, que es lo que ha llevado a SMIC a producir chips a una litografía equivalente a 7 nm, o menos. Al final hacen lo mismo más rápido y con menos recursos que con la maquinaria prohibida. Que, todo sea dicho, siguen obteniendo a través de terceros países, así que la prohibición solo dificulta un poco hacerse con ella.

Vía: Tom's Hardware.