Cerebras sigue iterando en su procesador a nivel de oblea y mostrando sus bondades. Ha demostrado que su servicio de inferencia basado en el Wafer Scale Engine de tercera generación (WSE-3) supera ampliamente a las soluciones de Amazon Web Services (AWS) en tareas de inteligencia artificial. En esta prueba, el WSE-3 ejecutó el modelo de lenguaje Llama 3.1, con 405 000 millones de parámetros, logrando generar 969 tókenes por segundo, un rendimiento 75 veces superior al de los servicios más rápidos de AWS usando aceleradoras. El tiempo hasta el primer token fue de solo 0.24 segundos, siendo un récord mundial.

La comparación consistió en una tarea práctica: generar un programa de ajedrez en Python. El sistema de Cerebras completó la tarea en solo tres segundos, mientras que Fireworks, el servicio de IA en la nube basado en aceleradoras tipo GPU, tardó cerca de 20 segundos en realizar la misma operación.

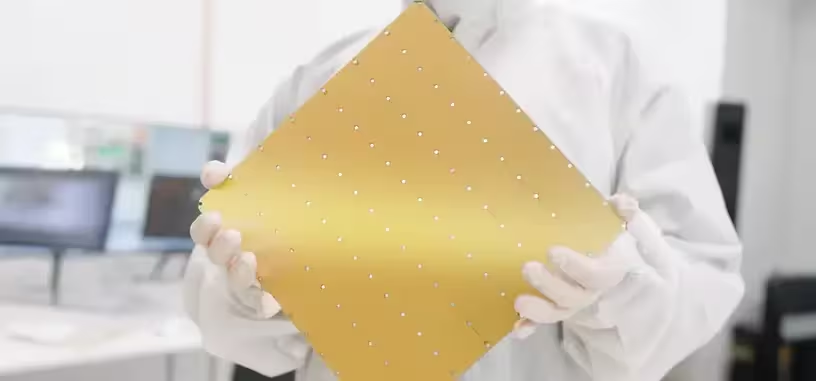

El WSE-3, conocido como el chip más grande del mundo porque abarca toda una oblea, está diseñado específicamente para aplicaciones de inteligencia artificial, evitando las limitaciones tradicionales de las GPU en tareas de este tipo. Con ese resultado de Llama 3.1, desde Cerebras aseguran que es doce veces más rápido que GPT-4o y dieciocho veces más rápido que Claude 3.5 Sonnet.

Vía: Tom's Hardware.