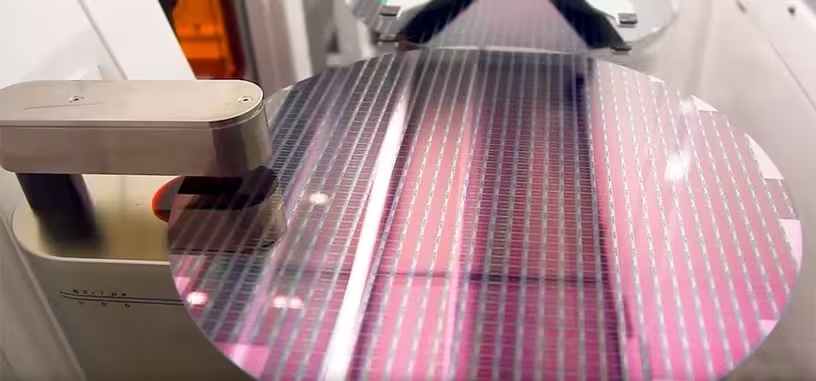

La memoria de alto ancho de banda (HBM) ha encontrado en los chips de inteligencia artificial su salida tras el futuro incierto que se abrió después de que AMD dejara de usarla en sus GPU de consumo. El auge de la inteligencia artificial generativa la ha vuelto a poner en el centro del sector que durante 2023 ha permitido que el descalabro de ventas de los fabricantes fuera menor. Pero entrados en 2024, la demanda de la HBM es absurda, llevando a que Micron asegure que su producción de HBM de todo el año está ya toda vendida.

Sigue así al anuncio de SK Hynix en la misma dirección. La principal ventaja de la HBM en este entorno es la alta capacidad de memoria que permite que tengan las aceleradoras, que ahora mismo se sitúa en al menos 24 GB por chip de HBM, frente a los 3 GB por chip de la GDDR. Es indispensable para la ejecución de los grandes modelos de lenguaje que se usa en la IAG.

«Ingresaremos varios cientos de millones de dólares por la HBM en nuestro año fiscal 2024», comentó el director ejecutivo de la compañía durante la presentación de resultados del primer trimestre de 2024, que va de diciembre a febrero, que técnicamente es su segundo trimestre fiscal de 2024. «El aumento de producción de la HBM restringirá el aumento de suministro del resto de productos».

Ahora mismo hay un aumento más que significativo de la demanda de DDR y GDDR, por lo que ahí lo tenéis, va a haber un aumento también de su precio de la DDR y GDDR, salvo que Samsung y SK Hynix aumenten significativamente su producción de DDR y GDDR. Pero con una demanda en aumento y los problemas de Samsung con la HBM, al menos SK Hynix también se centrará en la HBM, así que solo quedaría Samsung para aumentar la producción de DDR y GDDR y que los precios no suban en exceso.

Vía: Tom's Hardware.